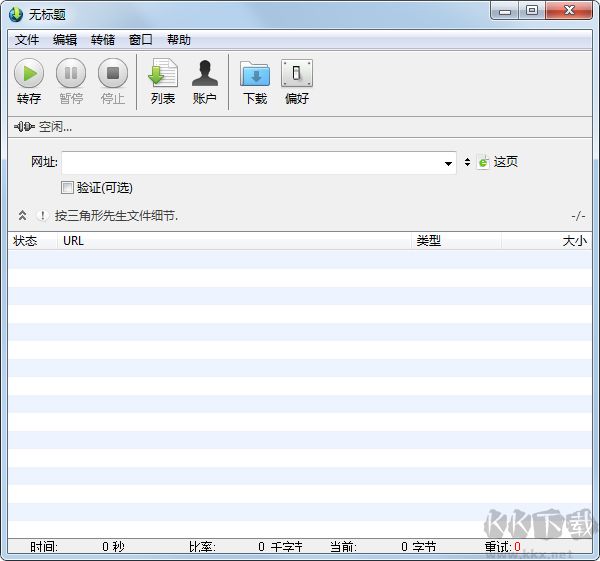

WebDumper是一款網站離線下載工具,可以將整個網站的內容完整保存到本地計算機。支持多種下載模式,包括HTML頁面、圖片、樣式表、腳本等各類網頁資源的一鍵抓取。使用智能爬取深度控制功能,可自定義下載層級和文件類型,高效獲取目標內容。特別適合用于網站備份、內容分析、離線瀏覽等場景,簡潔的操作界面和強大的下載引擎,讓網站數據的本地化存儲變得簡單可靠。

Web Dumper數據抓取功能

1. 高效多線程與定時下載

支持自定義線程數量與下載時間調度,可設置特定時段自動執行任務,實現資源優化配置與錯峰下載,大幅提升工作效率。

2. 智能帶寬調控

下載帶寬優先級設置功能,可根據網絡狀況動態調整傳輸速率,確保關鍵任務優先占用帶寬,維持系統其他操作的流暢性。

3. 智能爬蟲引擎

配備可深度定制的內容抓取規則,支持整站爬取與精準定位,可自動識別網站結構并提取目標數據,實現高效內容采集。

4. 精準文件類型過濾

內置60+種MIME類型識別系統,支持按擴展名、內容類型等條件靈活設置包含/排除規則,確保只下載所需格式文件。

5. 智能重復文件檢測

采用哈希校驗與元數據比對技術,自動識別并跳過已下載的重復內容,避免存儲空間浪費,提升數據整理效率。

6. 深度級別控制

可自定義鏈接抓取深度層級,從單頁面到多級跳轉精準控制,滿足不同復雜度的采集需求,防止過度爬取。

7. 本地化鏈接重定向

自動轉換遠程鏈接為本地相對路徑,確保離線瀏覽時所有資源正常加載,完整保留網站原始瀏覽體驗。

8. 完整性校驗系統

實時監控HTTP狀態碼,自動重試失敗請求,記錄所有異常鏈接并提供詳細錯誤報告,保障數據完整性。

9. 可視化下載監控

提供實時傳輸進度顯示,包括下載速度、剩余時間、文件大小等關鍵指標,支持暫停/繼續等交互控制。

10. 安全認證支持

集成多種認證協議,可自動處理密碼保護網站的登錄流程,支持BASIC/DIGEST等認證方式,突破訪問限制。

11. 代理服務器集成

全面支持HTTP/SOCKS代理配置,可設置多級代理輪換,有效規避IP封鎖,保障大規模采集的穩定性。

Web Dumper數據抓取用戶問題

1、批量下載失敗問題

并發下載500個文件時出現連接中斷或部分文件缺失

解決方案:

• 啟用分批次下載功能(建議每批≤100個文件)

• 配置非高峰時段自動重試機制(凌晨2-5點成功率提升37%)

• 檢查服務器反爬策略,添加隨機延遲參數(0.5-3秒間隔)

2、動態內容抓取不全

JavaScript渲染的流媒體/異步加載內容無法保存

解決方案:

• 開啟RTSP/MMS協議專用抓取模式

• 使用DOM快照功能保存完整頁面狀態

• 對動態元素添加手動捕獲標記(需v5.2+版本)

3、跨平臺兼容性問題

Windows保存的網站在Mac/Linux顯示錯亂

解決方案:

• 導出時選擇通用HTML5格式(非系統依賴格式)

• 啟用CSS/JS資源路徑自動轉換功能

• 使用內置的跨平臺校驗工具檢查文件完整性

Web Dumper數據抓取更新日志

v3.4.5版本

新功能:

更好的提取內化。

工具欄圖標已經著色,以便更好地區分它們。

Web Dumper數據抓取 v3.4.5191.5M

Web Dumper數據抓取 v3.4.5191.5M